Kafka 数据存储机制详解:从分区到日志文件的底层实现

Kafka 的高性能和高可靠性很大程度上依赖于其精巧的数据存储机制。从主题(Topic)的逻辑划分到分区(Partition)的物理存储,再到日志文件的分段与索引设计,每一层都经过优化以支持高吞吐、低延迟的消息读写。本文将以具体示例(3 个 Broker、3 个分区、2 个副本的主题)为切入点,深入解析 Kafka 数据存储的底层原理。

存储架构概览

Kafka 的数据存储遵循 “分层划分、分布式存储” 的原则,核心层次包括:

- 主题(Topic):逻辑概念,用于分类消息(如

first主题)。 - 分区(Partition):物理概念,每个主题分为多个分区(如 3 个分区),是并行读写的基本单位。

- 副本(Replica):每个分区有多个副本(如 2 个副本),实现高可用(Leader 副本处理读写,Follower 副本同步数据)。

- 日志段(LogSegment):每个分区的日志文件被拆分为多个片段(

.log数据文件 +.index索引文件),优化存储和查询效率。

以示例主题 first 为例(3 个 Broker、3 个分区、2 个副本),其存储架构如下:

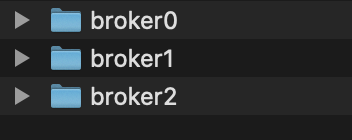

- Broker 分布:3 个 Broker(ID 为 0、1、2)。

- 分区副本分配:每个分区的 2 个副本分布在不同 Broker 上(如分区 0 的副本在 Broker 0 和 2 上)。

- Leader 选举:每个分区的 Leader 副本分散在不同 Broker 上(如分区 0 的 Leader 在 Broker 2,分区 1 的 Leader 在 Broker 0),实现负载均衡。

分区:数据存储的基本单元

分区的核心作用

- 并行扩展:多个分区可分布在不同 Broker 上,支持并行读写(如 3 个分区可同时处理 3 倍于单分区的吞吐量)。

- 顺序写入:消息按顺序追加到分区的日志文件(磁盘顺序写性能接近内存)。

- 偏移量(Offset):每个分区内的消息有唯一偏移量(从 0 开始递增),标记消息的位置(如分区 0 的第 1 条消息偏移量为 0,第 2 条为 1)。

分区的副本机制

以主题 first 为例,3 个分区的副本分配如下(信息存储在 ZooKeeper 的 /brokers/topics/first/partitions 节点):

| 分区 ID | 副本分布(Broker ID) | Leader 副本 | ISR 列表(同步副本) |

|---|---|---|---|

| 0 | [2, 0] | 2 | [2, 0] |

| 1 | [0, 1] | 0 | [0, 1] |

| 2 | [1, 2] | 1 | [1, 2] |

- Leader 副本:处理所有读写请求(如分区 0 的 Leader 在 Broker 2)。

- Follower 副本:从 Leader 同步数据(如分区 0 的 Follower 在 Broker 0),Leader 故障时可被选举为新 Leader。

- ISR 列表:与 Leader 保持同步的副本(包括 Leader 自身),只有 ISR 中的副本可参与 Leader 选举。

ZooKeeper 中的分区元数据

Kafka 通过 ZooKeeper 存储分区的元数据(如 Leader 位置、ISR 列表),路径为 /brokers/topics/<topic>/partitions/<partition>/state。例如:

分区 0 的状态(

get /brokers/topics/first/partitions/0/state):1

{"controller_epoch":2,"leader":2,"version":1,"leader_epoch":0,"isr":[2,0]}

含义:当前控制器世代为 2,分区 0 的 Leader 是 Broker 2,ISR 为 [2, 0]。

日志文件:消息的物理存储

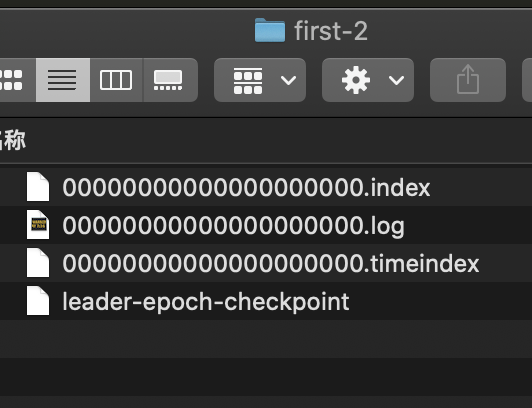

每个分区的副本对应一个日志目录(如 first-0 表示主题 first 的分区 0),目录下包含多个日志段(LogSegment),每个段由以下文件组成:

.log:存储消息的实际内容(二进制格式)。.index:偏移量索引文件,映射消息偏移量到.log中的物理位置。.timeindex:时间戳索引文件,映射消息时间戳到偏移量(用于按时间清理数据)。

日志段的命名规则

日志段的文件名以该段第一条消息的偏移量命名(如 00000000000000000000.log 表示起始偏移量为 0 的段)。当一个段的大小达到阈值(log.segment.bytes,默认 1GB)或时间达到阈值(log.roll.ms,默认 7 天)时,会创建新段(如 00000000000000001000.log 表示起始偏移量为 1000 的段)。

这种设计的优势:

- 快速定位:通过文件名可快速确定消息所在的段(如偏移量 1500 位于

00000000000000001000.log中)。 - 高效清理:删除老数据时只需删除整个段文件(如保留 7 天内的数据,直接删除 7 天前的段)。

.log 文件:消息的实际内容

.log 文件按顺序存储消息,每条消息包含以下核心字段(可通过 kafka.tools.DumpLogSegments 工具查看):

1 | 查看分区 0 的日志文件内容 |

输出示例:

1 | offset: 0 position: 0 CreateTime: 1622528888699 ... payload: bb |

- offset:消息在分区内的唯一标识(0、1、2…)。

- position:消息在

.log文件中的物理字节位置(如偏移量 0 的消息位于文件第 0 字节,偏移量 1 的消息位于第 70 字节)。 - payload:消息体内容(如

bb、dd)。

.index 文件:稀疏索引加速查询

.index 文件是稀疏索引(非每条消息都有索引),用于快速定位消息在 .log 中的位置,格式为 “偏移量 → 物理位置” 的映射(每个条目 8 字节:4 字节偏移量 + 4 字节位置)。

查看索引文件内容:

1 | bin/kafka-run-class.sh kafka.tools.DumpLogSegments \ |

输出示例:

1 | offset: 64 position: 4616 |

- 索引间隔:每隔

log.index.interval.bytes(默认 4096 字节)创建一条索引,平衡索引大小和查询效率。 - 查询流程:

- 给定目标偏移量(如 70),通过二分查找

.index文件,找到小于等于 70 的最大偏移量(如 64)。 - 从

.log文件的对应位置(4616 字节)开始顺序扫描,找到偏移量 70 的消息。

- 给定目标偏移量(如 70),通过二分查找

.timeindex 文件:按时间管理数据

.timeindex 文件存储 “时间戳 → 偏移量” 的映射(每个条目 12 字节:8 字节时间戳 + 4 字节偏移量),用于按时间范围查询或清理数据(如删除 7 天前的消息)。

Kafka 通过 .timeindex 快速定位超过保留时间的段,直接删除整个段文件,避免逐条消息检查。

数据读写流程

写入流程(生产者 → Broker)

- 分区路由:生产者根据消息的 Key 或默认策略(轮询)确定目标分区(如分区 0)。

- Leader 写入:消息发送到分区的 Leader 副本(如 Broker 2 的分区 0),追加到

.log文件末尾(顺序写)。 - 索引更新:当写入字节数超过

log.index.interval.bytes时,更新.index和.timeindex文件。 - Follower 同步:Follower 副本(如 Broker 0 的分区 0)从 Leader 拉取消息,重复步骤 2-3,同步完成后通知 Leader。

- 确认应答:Leader 收到足够多 ISR 副本的同步确认后(根据

acks配置),向生产者返回成功。

读取流程(消费者 → Broker)

- 定位分区:消费者根据分配的分区(如分区 0)向 Leader 副本(Broker 2)发送拉取请求,指定起始偏移量(如 50)。

- 段定位:根据偏移量 50 确定目标日志段(如

00000000000000000000.log)。 - 索引查询:在

.index文件中查找偏移量 50 对应的物理位置(如通过二分法找到最近的索引 40 → 位置 2000)。 - 日志扫描:从

.log文件的 2000 字节位置开始扫描,读取偏移量 50 及之后的消息。 - 返回结果:将消息返回给消费者,消费者更新本地偏移量(如从 50 推进到 60)。

关键配置与性能优化

| 配置参数 | 作用 | 默认值 | 优化建议 |

|---|---|---|---|

log.segment.bytes |

单个日志段的最大大小 | 1GB | 大消息场景增大(如 2GB),小消息场景减小(如 512MB)。 |

log.index.interval.bytes |

索引间隔(每写入多少字节创建一条索引) | 4KB | 大消息场景增大(如 8KB),减少索引文件大小。 |

log.retention.ms |

消息保留时间 | 7 天 | 非核心数据缩短保留时间(如 1 天),减少磁盘占用。 |

log.retention.bytes |

分区的最大保留字节数 | -1(无限制) | 磁盘紧张时设置上限(如 100GB)。 |

v1.3.10