Eureka 架构深度解析:基于 AP 原则的服务发现设计

Eureka 作为 Netflix 开源的服务发现组件,其架构设计严格遵循AP 原则(可用性优先,兼顾分区容错性),通过独特的集群模式和自我保护机制,在分布式系统中实现了高可用的服务注册与发现能力。本文将从分布式系统的 CAP 取舍出发,详解 Eureka 的架构设计、核心机制及与 Zookeeper 的本质区别。

分布式系统的 CAP 取舍:为什么 Eureka 选择 AP?

在分布式系统中,一致性(Consistency)、可用性(Availability)、分区容错性(Partition Tolerance) 三者不可兼得,必须根据业务场景取舍:

- 一致性(C):所有节点同时看到相同的数据(强一致性);

- 可用性(A):集群中任一节点故障时,其他节点仍能正常响应请求;

- 分区容错性(P):网络分区(部分节点通信中断)时,系统仍能继续工作(分布式系统必选)。

因此,分布式系统只能在 CP(优先一致性)或 AP(优先可用性)中选择:

- CP 系统:保证数据一致,但网络分区时可能暂时不可用(如 Zookeeper);

- AP 系统:保证服务可用,但数据可能短暂不一致(最终一致)(如 Eureka)。

Eureka 选择 AP 原则的核心原因是:微服务架构中,服务可用性比强一致性更重要。

- 即使服务注册表数据暂时不一致(如某节点未及时同步新服务),只要服务能正常调用,系统仍可运行;

- 若为了强一致性牺牲可用性(如 Zookeeper 选举期间服务不可用),会导致整个微服务调用链中断。

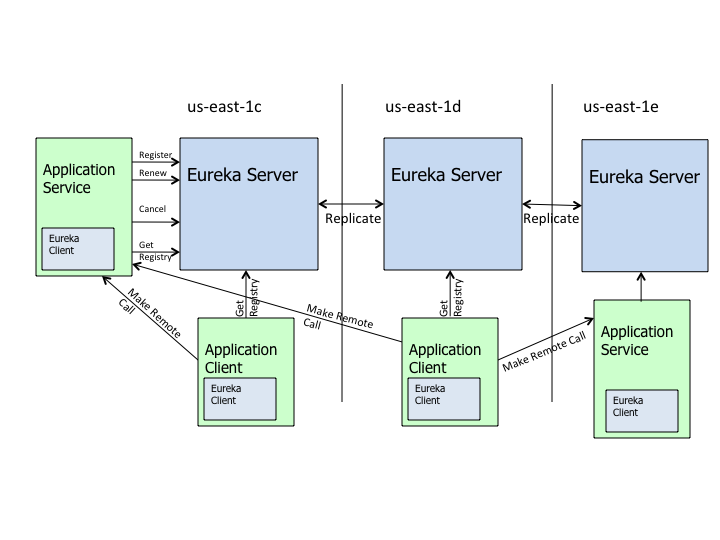

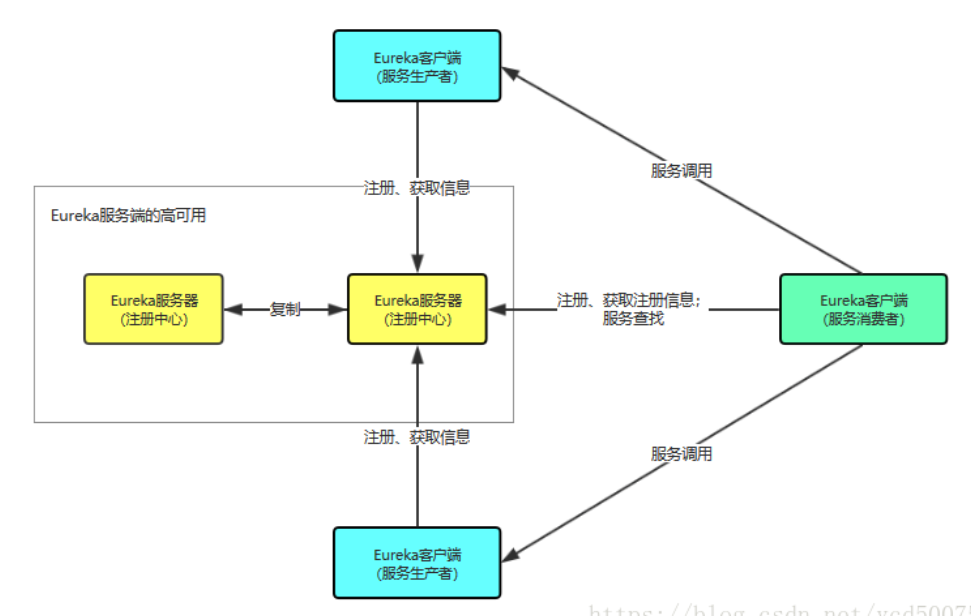

Eureka 核心架构:C-S 模式与集群设计

Eureka 采用客户端 - 服务器(C-S)架构,核心组件包括 Eureka Server(注册中心)和 Eureka Client(服务提供者 / 消费者),整体架构如下:

1. 核心组件及交互流程

- Eureka Server:

- 核心功能:提供服务注册接口,存储所有可用服务的元数据(IP、端口、状态等);

- 集群模式:多节点对等部署(无主从之分),节点间通过异步复制同步服务注册表。

Eureka Client:

- 服务提供者:启动时向 Eureka Server 注册自身信息,定期发送心跳(默认 30s / 次)证明存活;

- 服务消费者:启动时从 Eureka Server 拉取服务列表并缓存到本地,通过服务名调用接口(内置轮询负载均衡)。

2. 集群数据同步机制

Eureka Server 集群采用对等节点设计(无主从),核心特点:

- 任一节点均可接收服务注册请求,无需转发至 “主节点”;

- 注册信息通过异步复制同步到其他节点(最终一致性);

- 少数节点故障不影响整体可用性(其他节点仍可提供服务)。

这种设计避免了 “主节点选举” 的开销,保证了集群的高可用性,但可能导致短期内节点间数据不一致(如 A 节点注册的服务,B 节点暂时未同步)。

Eureka 核心机制:自我保护与服务健康管理

Eureka 的高可用性很大程度上依赖于自我保护机制和心跳检测,两者共同保证服务注册表的准确性和系统的稳定性。

1. 心跳检测与服务剔除

- 心跳机制:服务提供者每 30s 向 Eureka Server 发送心跳(

PUT /eureka/apps/{服务名}/{实例ID}),证明自身可用; - 服务剔除:若 Eureka Server 90s 未收到心跳(可通过

lease-expiration-duration-in-seconds配置),会将该实例标记为 “失效”,并在后续周期(默认 4s)中从注册表中剔除。

2. 自我保护机制:避免网络波动导致的误判

(1)触发条件

当 Eureka Server 短时间内丢失大量心跳(如网络分区),满足 (上一分钟收到的心跳数 / 期望心跳数) < 0.85 时,触发自我保护模式。

期望心跳数(Renews threshold):根据当前注册的服务实例数计算(每个实例每分钟发送 2 次心跳);实际心跳数(Renews (last min)):上一分钟内实际收到的心跳数。

(2)保护模式下的行为

进入自我保护模式后,Eureka Server 会:

- 不再从注册表中删除 “失效” 服务(避免因网络问题误删健康服务);

- 仍接受新服务注册和查询请求,但新注册信息不会同步到其他节点(保证当前节点可用);

- 网络恢复后(心跳数回升至阈值以上),自动退出保护模式,同步数据至其他节点。

(3)配置与建议

- 本地测试可关闭:

eureka.server.enable-self-preservation=false; - 生产环境强烈建议开启:避免网络波动导致正常服务被误删。

Eureka vs Zookeeper:AP 与 CP 的本质区别

| 维度 | Eureka(AP) | Zookeeper(CP) |

|---|---|---|

| 一致性模型 | 最终一致性(节点数据异步同步) | 强一致性(ZAB 协议,写操作需多数节点确认) |

| 集群架构 | 对等节点(无主从),异步复制 | 主从架构(Leader 处理写请求,Follower 同步) |

| 可用性 | 网络分区时仍可用(数据可能不一致) | Leader 选举期间不可用(约 30-120s) |

| 服务注册 | 任一节点均可接收,即时可用 | 仅 Leader 可处理,选举期间注册失败 |

| 适用场景 | 微服务架构(优先保证服务可用) | 分布式协调(如分布式锁、配置中心) |

核心差异:服务注册的可用性保障

- Zookeeper 为保证强一致性,Leader 故障时需重新选举,期间服务注册完全不可用;

- Eureka 无主从之分,任一节点故障不影响其他节点,网络分区时仍能提供服务(数据最终一致)。

Eureka 架构的优势与局限性

优势

- 高可用性:对等集群 + 自我保护机制,网络波动或节点故障时仍能提供服务;

- 客户端缓存:服务消费者缓存服务列表,Eureka Server 宕机后仍可调用服务;

- 轻量易用:与 Spring Cloud 无缝集成,配置简单,学习成本低。

局限性

- 一致性弱:节点间数据异步同步,可能出现短期不一致;

- 功能单一:仅支持服务注册发现,无配置管理、限流等扩展功能;

- 官方停更:Netflix 已停止 Eureka 2.x 开发,依赖社区维护。

总结

Eureka 基于 AP 原则的架构设计,完美契合了微服务架构对 “可用性” 的核心需求。通过对等集群、自我保护机制和客户端缓存,在分布式环境中实现了高可用的服务注册与发现。尽管与 Zookeeper 等 CP 系统相比一致性较弱,但其在服务可用性上的优势,使其成为中小规模微服务架构的理想选择

v1.3.10